Agent

Agent定义

说到"Agent"这个词,我发现在AI圈里经常会引起混乱,大家聊着聊着就得停下来确认一下到底在说什么。这个概念其实有着挺有趣的演变历程。

最早的时候,Agent这个概念来自强化学习领域。那时候我们说的Agent,就是那种能跟环境互动、有明确目标、会从经验中学习、还能主动尝试新动作的"智能体"。核心思想就是在"探索"和"利用"之间找平衡——既要利用已知的好策略,又要勇于尝试未知的可能性。

但是自从大语言模型火了之后,整个行业对Agent的理解就变了。现在大家提到Agent,更多指的是基于LLM搭建的、能够自主完成复杂任务的智能系统。这种新Agent更注重在现实世界中做决策和执行任务,强调的是"自主性"和"实用性"。

虽然有些人希望这种新Agent也能像强化学习中的Agent那样具备"自主进化"的能力,但说实话,两者的底层逻辑和关注点其实挺不一样的。

现在业界对"Agent"基本有两种理解方式:

- 泛指:就是指任何具备一定自主性的智能体

- 特指:专门指基于大模型、能自主完成复杂任务的AI系统

回顾AI的发展历程,我们经历了从规则系统到深度学习,再到现在的LLM时代。早期的AI更像是"工具",你给它指令,它就执行。而Agent的出现,标志着AI开始主动规划和执行任务了。

这个转折点我觉得就是2023年GPT-4的发布。GPT-4大幅提升了大模型的推理、规划和多任务处理能力,让AI不仅能理解复杂指令,还能自主分解任务、调用工具、完成多步操作。紧接着AutoGPT、BabyAGI这些开源项目的出现,更是让Agent的落地应用成为了可能。

在实际应用中,我发现大多数所谓的"agentic system"其实都是workflow和agent的混合体。所以我现在不太纠结某个组件到底算不算agent,更关心的是一个系统到底有多"agentic"。

In practice, we see that most “agentic systems” are a combination of workflows and agents. This is why I actually hate talking about whether something is an agent, but prefer talking about how agentic a system is.

在实际中,我们发现大多数"agentic system"都是workflow和agent的组合。这也是为什么我其实不喜欢讨论某个东西是不是一个agent,而是更倾向于讨论一个系统有多么"agentic"

Agent的自主程度

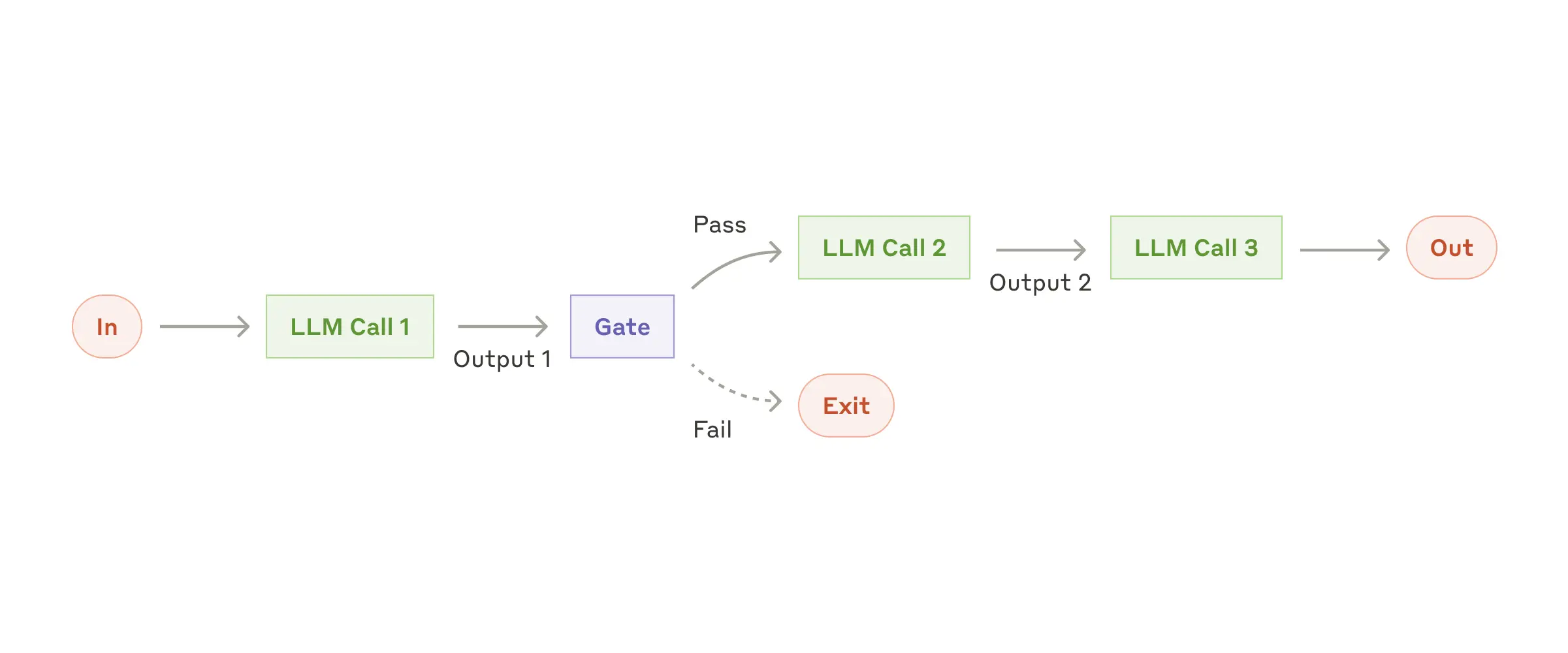

Prompt Chaining:

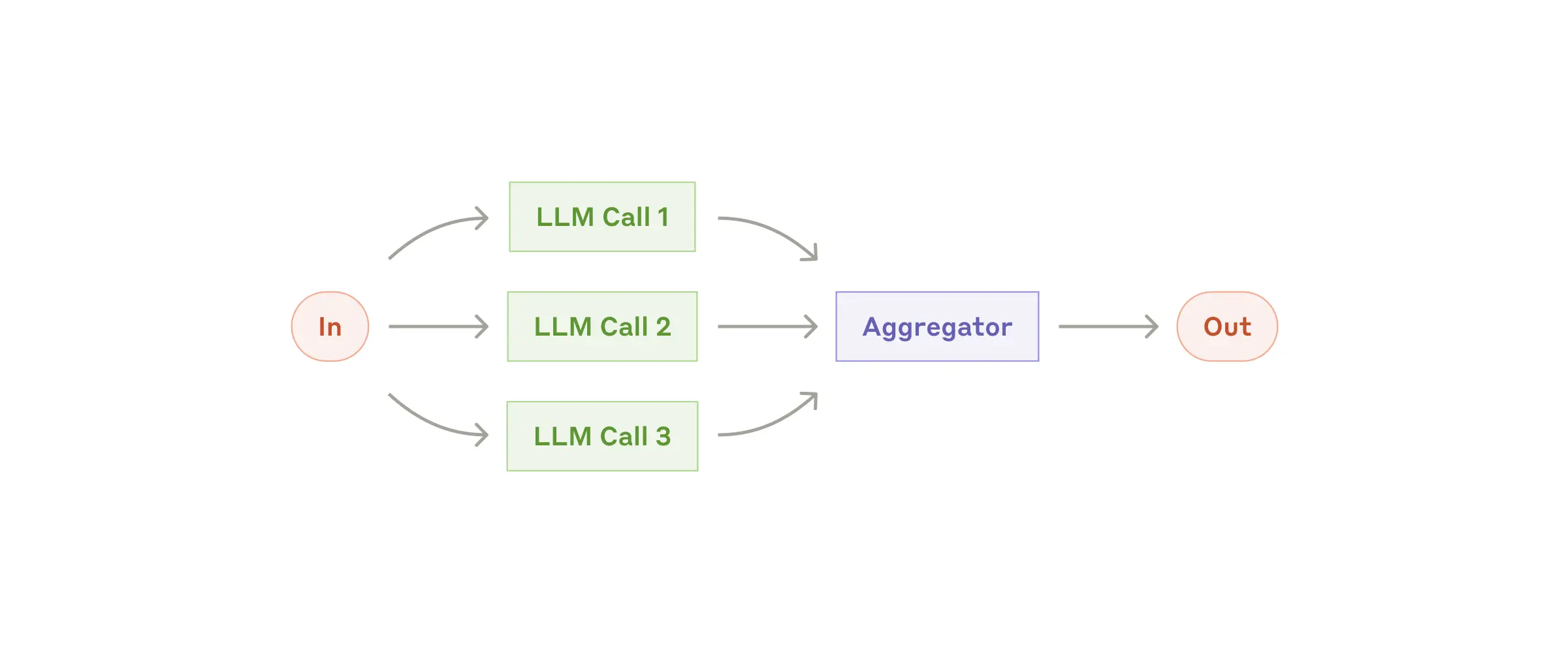

Parallelization:

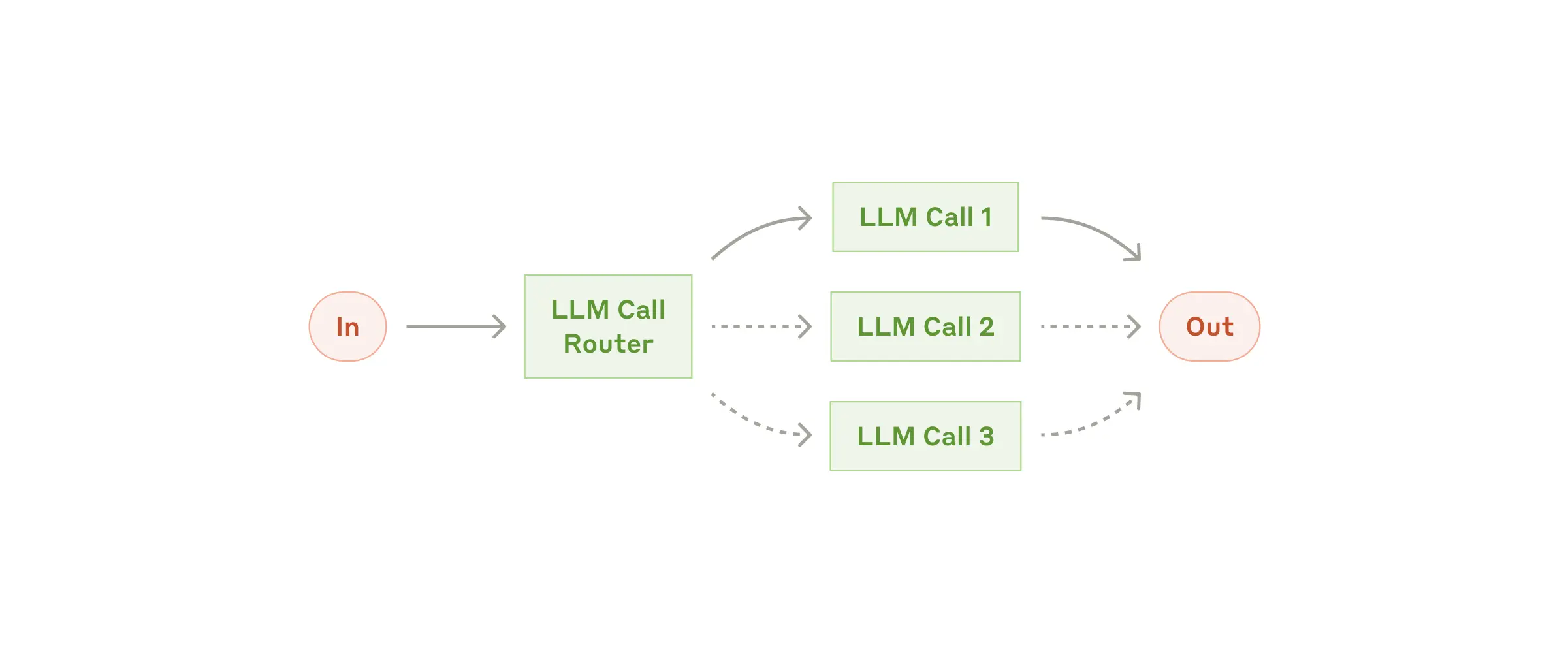

Routing:

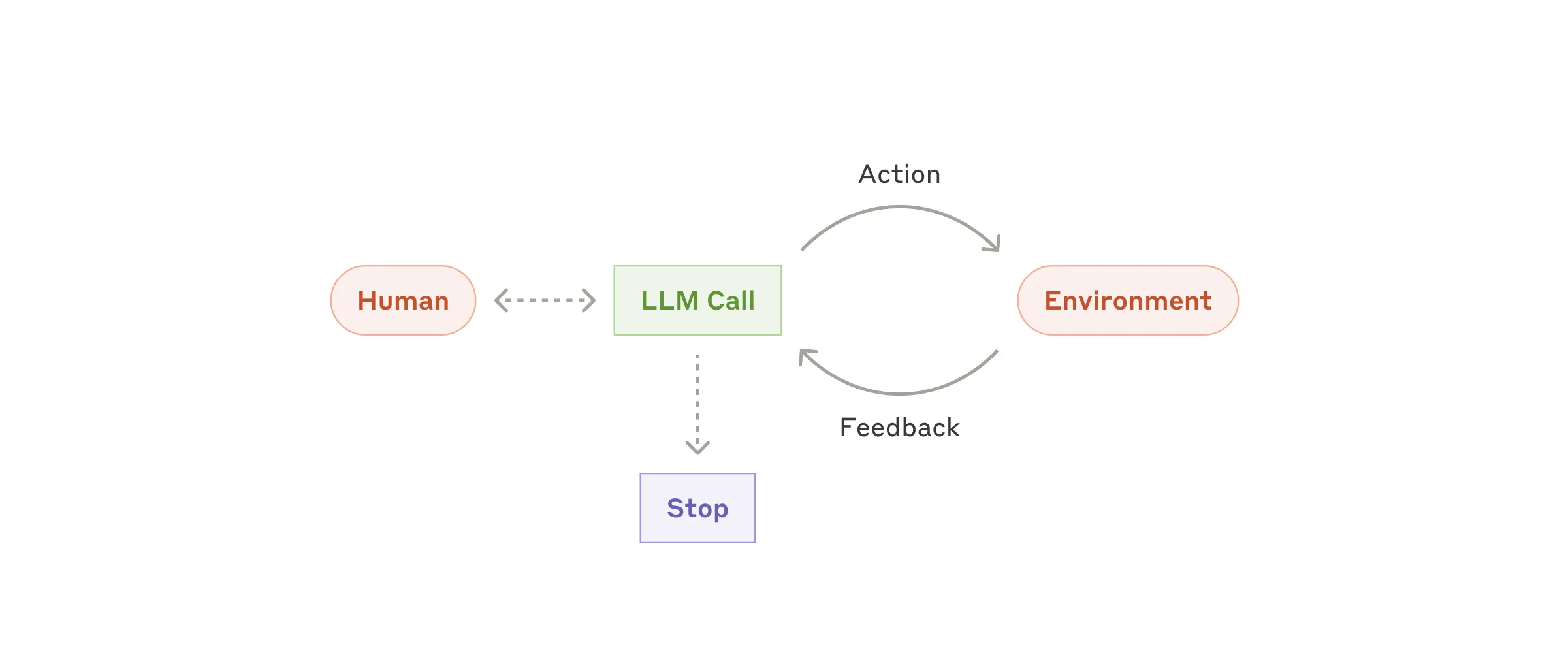

Autonomous Agent:

看了这几种模式,我觉得它们的区别主要在于自主性的程度:

- Prompt Chaining:模型调用是顺序执行的,整个流程的每一步和执行顺序都在设计时被确定,属于静态、串行的执行模式。

- Parallelization:多次模型调用可以并行进行,但和Prompt Chaining一样,所有调用的执行路径和任务分配在设计时已明确,依然属于静态编排,只是执行方式由串行变为并行。

- Routing:系统在多个LLM调用节点中,根据输入数据动态选择其中一个执行。这种模式下,虽然所有可能路径在设计时已预设,但具体走哪条路径要等到实际输入时才确定,类似于代码中的条件分支(if-else)。

- Autonomous Agent:相比Routing,这种模式的自主性更高,执行路径和具体动作无法在设计时提前确定。系统根据当前环境和上下文,动态决策每一步的行动和流程,甚至执行轮数本身也是不确定的。

这几种Agentic System的设计模式,体现了不同层次的自主性,其本质区别在于系统执行路径的决策时机:

- 静态编排(Prompt Chaining & Parallelization):执行流程完全由设计师在系统构建时确定,像一张详尽的蓝图,系统只需按部就班地执行。

- 动态编排(Routing):所有可能的执行路径预先设定,但实际运行中根据输入数据实时选择具体路径。好比准备了多套应对方案,实际选择由现场情况决定。

- 自主编排(Autonomous Agent):系统无法提前预见所有可能路径,执行流程和步骤都需根据实时环境和动态反馈即时决策。类似前线将军权宜应变,具备更高的自主性和灵活性。

总体来看,随着系统自主性的提升,从Prompt Chaining到Autonomous Agent,系统对复杂问题的处理能力增强,但人类工程师对系统行为的可控性则逐步降低,系统行为也变得更动态和不可预测。

Agent设计

说实话,设计一个好用的Agent系统,绝不只是会写代码或者懂算法就够了。这是个涉及多个层面的系统工程,我觉得需要从几个角度来思考。

1. 需求与技术的双重理解

首先得搞清楚,到底在什么场景下用AI Agent才真的有价值?

我的经验是,你得同时做两件事:

- 梳理业务流程:深入了解实际的业务流程,找出哪些环节最耗时、最容易出错、最值得优化

- 评估技术能力:同时要清楚当前AI技术的边界,比如大语言模型擅长文本生成、知识检索和多轮对话,但对于高度结构化、强规则性的决策场景可能就不太行了

2. 用户交互与功能边界

Agent要以什么形式为用户服务?这个问题很关键:

- Chatbot:用户通过自然语言跟Agent聊天,适合信息查询、简单任务处理

- Human-in-the-loop系统:Agent自动干活,但在关键节点让人来审核,确保不出大问题

- 复杂交互系统:比如"低代码自动化平台",用户通过可视化界面下达复杂指令,Agent负责拆解任务和反馈结果

举个例子: 像Cursor或Cline这样的AI编程助手,Agent可以根据开发者的需求自动生成代码、补全函数或者提重构建议。但最终代码要不要用、怎么集成到项目里,还是得开发者说了算。开发者不仅可以修改或者拒绝AI的建议,还能给AI反馈,帮助系统不断优化。

3. Agent粒度与流程拆解

当产品形态明确后,应进一步将业务流程拆解成更细致、目标更明确的子流程。每个子流程都可以由独立的Agent负责,协同完成复杂任务。

Multi-agent system(多智能体系统):多个Agent并行协作,完成复杂流程

- 业务流程被拆分为多个子流程,每个子流程由一个或多个Agent负责。

- 比如在客服系统中,可有不同Agent处理用户咨询、投诉、售后等任务,各自独立但整体协同。

- 拆分标准通常依据Agent的能力边界或任务目标。

BPM(Business Process Management):提供流程拆解基础,明确子流程边界

- BPM 提供了业务流程的全局视图(如用流程图表示各步骤、输入输出)。

- 基于BPM的流程建模结果,我们可以识别哪些流程可以交由Agent承担。

- 例如,在电商订单流程中,“支付处理”、“库存校验”、“发货通知”可建模为独立节点,进而分配给专门的Agent。

SOP(Standard Operating Procedure):保障每个Agent行为一致、标准化

- 每个Agent所承担的子流程都应有明确的SOP,作为其执行策略的基础。

- SOP 使Agent行为具备一致性和可预测性,即便在多Agent同时工作时也能保障流程不混乱。

- 例如:发票生成Agent依据SOP自动调用接口、格式化内容、存储与发送。

DDD(Domain-Driven Design): 指导如何划分Agent的职责范围

- 拆解Agent时,DDD 提供一种按“业务语义”划分责任的原则:将每个Agent视为一个限界上下文(Bounded Context)中的服务单元。

- DDD 有助于识别哪些职责应归属于哪个Agent,从而避免职责重叠或不清。

- 例如,在物流领域中,“运输调度Agent”和“包裹跟踪Agent”分别承担不同领域的逻辑,职责清晰。

4. Agent 的价值

通用Agent

OpenAI 的 Deep Research,以及 OpenAI 新发布的 o3 模型,就是一个标准的模型即 Agent的范例。

它把 Agent 的所有组件——大语言模型(LLM)、上下文(Context)、工具使用(Tool Use)和环境(Environment)全都缝合到了一起,并进行了端到端的强化学习训练。在训练过程中,o3不仅仅接受静态的数据输入,还可以和“环境”进行交互。比如,Agent可以主动发起检索、收集信息、反馈成果,环境会实时返回结果和变化(例如API响应、外部数据库返回),Agent根据这些反馈调整自己的行为。训练之后的结果就是,各类 Agent 执行信息检索的任务它都能完成。

垂直Agent

在ToB(面向企业)的垂直领域,AI Agent的角色可以类比为企业中的“前台”和“后台”两类工作。不同类型的任务,对AI Agent的能力和系统设计提出了不同要求。

1.后台工作——流程自动化与多智能体系统

后台工作通常具有高重复性、对高并发有严格要求,并且流程长、环节多,常常依靠一套详细的标准操作流程(SOP, Standard Operating Procedure)来保障效率与规范。许多此类任务非常适合由AI Agent进行一对一的自动化执行,特别适合在广阔的任务空间里通过强化学习不断优化表现。

举例说明: 以AI for Science领域的创业公司为例,他们构建的是多智能体系统,能够自动完成诸如文献检索、实验规划、前沿趋势预测、数据分析等多种科研任务。与传统的单Agent系统(如OpenAI Deep Research)不同,这类系统可以针对科研流程的每一个细分环节分配专属Agent,实现更高分辨率的任务分工。例如,Contradiction Finding(矛盾发现)功能能自动检测并分析两篇顶级学术论文之间的观点冲突,极大提升了科研工作的深度和创新性。

2.前台工作——人机交互与语音Agent

前台工作往往需要频繁与人沟通,更多聚焦于客户服务、外联和实时响应。当前,语音类AI Agent在这些场景中展现出独特价值,尤其适用于需要全天候、高效沟通的任务。

举例说明: 在医疗、招聘、物流等行业,AI语音Agent可以承担如护士电话回访、求职者初筛、物流订单跟进等工作。例如,有创业团队专注于物流和供应链领域的电话沟通,Agent能够在司机遇到异常或货物到站时,第一时间自动致电相关人员,提供问题解答和快速响应。AI Agent具备7天24小时无休工作的能力,极大提升了服务的及时性与覆盖面,满足了物流行业对高效沟通的核心诉求。

5. Agent和动物行为

河狸能够建造复杂的水坝和巢穴,这种行为究竟是源于有意识的推理能力,还是仅仅依赖于本能和模式识别?我们是否可以把河狸的基因看作类似于通过进化“训练”出来的强化学习模型,而这些复杂行为的产生其实并不需要高级的自我意识?

进化论与强化学习:河狸的智能密码

基因是强化学习的预训练模型

有意识推理 vs 模式识别

我们先搞清楚,有意识的推理是啥样。那得是人类工程师造大坝,得画图纸,算流体力学,搞成本分析,还得开会扯皮。而河狸呢?它看到流动的河水,听到哗哗的水声,DNA里某个开关就被"啪"地一声打开了。它不是在思考"我为什么要建大坝来抬高水位以躲避天敌",它只是在执行一套刻在基因里、被优化了数百万年的"IF-THEN"指令集。IF听到水流声,THEN开始搬木头堵上。

但这里要澄清一点:河狸并非完全是僵化的"IF-THEN"机器。研究显示它们其实具有相当的灵活性——能根据水流速度调整坝的设计,学会使用新材料(比如人造物品),在不同环境中展现创新性解决方案。这提醒我们,“有意识推理"和"模式识别"之间的界限,可能比我们想象的更加模糊。

结构主义(模式识别)

核心逻辑:

结构主义的基本观点很简单:万物的意义来自差异,而非本质。

索绪尔研究语言时发现,“猫"之所以是"猫”,不是因为它的内在属性,而仅仅因为它不是"狗”、“鼠”、“杯”。一个符号的意义,完全由它在系统中与其他符号的差异关系决定。

分形特征:

这个"通过差异定义身份"的逻辑,在不同层次上反复出现:

语言学层面:词汇通过相互区分获得意义 人类学层面:列维-斯特劳斯用"生/熟"、“干/湿"等二元对立分析神话结构 社会学层面:“精英"身份通过与"大众"的差异得以确立 物理学层面:基本粒子的属性(电荷、自旋)在相互关系中被定义

连原子的身份都是如此——氧之所以是氧,就因为它有8个质子,区别于氮的7个和氟的9个。

边界与局限:

然而,将结构主义视为宇宙本体是错误的。结构主义的核心是"意义”,而意义是人类的产物。两块石头本身并无差异感知,只有当人类观察并比较时,“差异"和"意义"才产生。因此,结构主义更像是人类认知的内置软件,一个"认知分形”,而非世界的本来面目。

后结构主义的挑战:德里达指出,那些看似稳定的二元对立结构,实际上充满权力关系和不确定性。意义在无限的符号链条中滑动,永远无法固定。

结构主义是一个强大的分析工具,一种普适的认知模式。但它不是世界本身,而是人类理解世界的方式。

世界按自然规律运行,人类通过构建差异化结构来理解它,顺便为存在赋予意义。

进化版强化学习的类比

在AI领域,强化学习就是一个智能体在环境里瞎折腾,做对了给个"糖”(奖励),做错了给个"巴掌"(惩罚),最终学会一套能获得最多糖的行动策略。

而在进化论这个宏大的舞台上:

- 智能体是谁? 是整个物种,比如河狸这个集体。

- 环境是什么? 是残酷的大自然。

- 训练周期有多长? 数百万年。

- 动作尝试是什么? 是基因的随机突变。

- 奖励和惩罚是什么? 是自然选择的铁律:能活下来并成功繁殖,就是最大的奖励;死了或者绝后了,就是终极的惩罚。

经过这长达数百万年、以亿万生命为代价的"训练",最终得到了什么?就得到了今天河狸的基因组(Genome)——一个完美的"预训练模型"!

多层次的学习架构

但这个预训练模型比我们想象的更加精妙,因为河狸的智能其实是多层学习的结果:

物种层面:数百万年的进化优化预训练部分,奠定了基础的生存框架。

个体层面:每只河狸一生中的经验学习和技能精进,这相当于在预训练模型基础上的个性化微调。

文化层面:河狸家族间的行为传承,年长的河狸会向年幼的传授筑坝技巧,这类似于知识蒸馏(Knowledge Distillation)。

这个模型出厂就预装了所有生存必备的"软件",包括如何啃木头、如何消化纤维,以及最重要的,那套天衣无缝的筑坝程序。每一只新生的河狸,都是一个加载了顶级预训练模型的"实例"。它不需要从零开始上建筑课,它生来就是老手。

涌现的悖论

所以别再给河狸加戏了,人家根本不是什么"建筑师",而是天选打工人,自带出厂设置,还是百万年迭代优化过的顶级旗舰版。它的行为,基本不需要"高级意识"的参与。

但这里隐藏着一个让人着迷的悖论:一个看似"没有智能"的过程(随机突变+自然选择),竟然能够产生出如此精妙的"类智能"行为。进化这个算法确实没有预设目标,但说它完全"盲眼"可能低估了自然选择的精妙——它更像是一个极其敏感的优化器,能够探测到环境中最细微的适应性差异。

这种看似充满智慧和目的性的复杂行为,其"智慧"并不存在于单个河狸的大脑里,而是编码在整个物种的基因里。这份智慧,是"进化"这个宏伟、无情、但又极其强大的优化算法,“算"出来的最优解。

人类智能

如果河狸是"预训练模型+微调”,那人类呢?我们的文化、语言、理性思维,是否也是同样机制的产物?这个类比让我们重新审视人类智能的独特性。

也许我们引以为豪的"有意识推理",在某种程度上也是基于数百万年进化优化的神经网络结构,再加上文化传承的"知识库",以及个人经验的"微调"。

世界的本质:涌现而非设计

你看,从结构主义到河狸筑坝绕了一大圈,最终发现了一个共同点:无论是人类社会创造的"意义",还是自然界演化出的"智能",其背后都可能是一个宏大的、去中心化的、由底层规则和结构涌现出的结果。它们都不需要一个高高在上的、拥有绝对意识的"指挥官"。

但这并不意味着世界完全"没有心"。复杂系统中的涌现现象往往产生出我们无法预期的"类心智"特性。也许"心智"本身就不是一个二元的存在/不存在的概念,而是一个连续的谱系——从最简单的反应机制,到河狸的复杂行为,再到人类的抽象思维。

这个世界,或许比我们想象的要更加自动化,但同时也更加神秘和精妙。最复杂的智能行为,往往来自最简单规则的长期迭代。这不仅适用于生物进化,也适用于AI发展,甚至人类文明的演进。

在这个意义上,河狸确实是大自然的杰作——一个完美展示了"无心之智"的生动例证。